A/B-тестування (іноді його також називають спліт-тестуванням) — популярний метод UX-досліджень, що набув широкого поширення в різних галузях.

У сьогоднішній статті ми розберемо:

- навіщо проводити A/B-тести,

- як підготуватися до їх проведення,

- які обмеження та поширені помилки зустрічаються в цій галузі.

A/B-тестування (іноді його також називають спліт-тестуванням) — популярний метод UX-досліджень, що набув широкого поширення в різних галузях. Щоб завжди отримувати надійні, по-справжньому цінні результати, дотримуйтесь кращих практик і уникайте поширених помилок, які ми розберемо в цій статті.

Що таке A/B тестування?

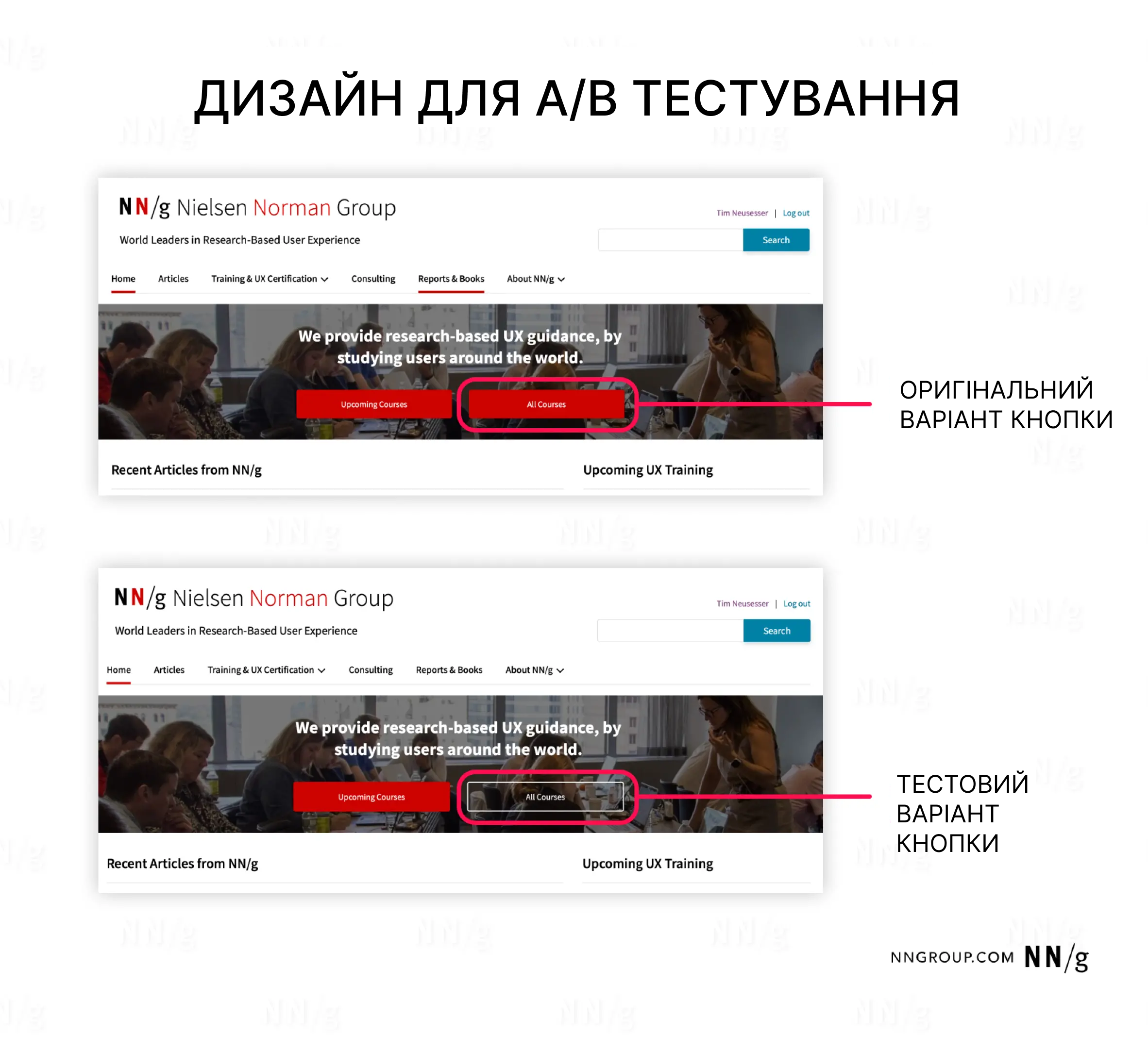

A/B-тестування — це метод кількісного дослідження, при якому користувачам показують дві або більше версій дизайну з метою визначити, яка з них є ефективнішою за заздалегідь визначеними метриками.

Для проведення A/B-тестування необхідно мати реалізований продукт. Зазвичай порівнюють оригінальну версію дизайну (A), яку називають контрольною, з альтернативною версією (B), що є варіантом. Ідеально, якщо відмінність між варіантами полягає лише в одному елементі — наприклад, кнопці, зображенні або тексті — що дозволяє точно визначити, який фактор вплинув на результат.

Під час A/B-тесту вхідний трафік розподіляється так, щоб кожен користувач потрапляв на одну з версій тестової сторінки. Розподіл може бути рівномірним (50/50) або відкоригованим залежно від бізнес-цілей і потенційних ризиків. Наприклад, якщо зміна дизайну для половини користувачів вважається занадто ризикованою, відсоток трафіку можна змінити.

Перед початком тестування важливо визначити список метрик, які допоможуть оцінити, яка версія дизайну краще стимулює бажану поведінку користувачів і відповідає цілям компанії.

Зазвичай (але не завжди), якщо варіант B статистично значуще перевершує оригінальний дизайн A, його варто зробити основним. Якщо ж тест не дає результатів або оригінальний дизайн виявляється ефективнішим, слід залишити його, розглядаючи інші альтернативні варіанти для подальших тестів.

Навіщо проводити A/B-тести

A/B-тести допомагають командам визначити, як покращити користувацький досвід (UX) для успішного досягнення бізнес-цілей. Вони дають змогу приймати більш обґрунтовані дизайн-рішення, що сприяють підвищенню окупності інвестицій (ROI) та спрощують комунікацію з зацікавленими сторонами.

Завдяки A/B-тестам ви можете поступово вдосконалювати свій продукт, роблячи його зручнішим та ефективнішим, не вдаючись до кардинальних змін.

Для A/B-тестування необхідно використовувати чіткі метрики, які однозначно показують, чи перевершує один варіант інший. Зазвичай вони зосереджені на фінансових показниках, таких як дохід або витрати.

Найпопулярніші метрики для A/B-тестування:

- Коефіцієнт конверсії,

- Коефіцієнт кліків (CTR),

- Коефіцієнт відмов,

- Коефіцієнт утримання,

- Дохід на одного користувача.

Найчастіше A/B-тестування застосовується в таких сферах:

- Електронна комерція (Amazon),

- Розважальні продукти (Netflix, Spotify),

- Соціальні мережі (Instagram, TikTok),

- SaaS-продукти (Salesforce, Office365),

- Онлайн-видання (The New York Times),

- Email-маркетинг.

Елементи дизайну, які найчастіше тестуються:

- CTA-кнопки (заклики до дії),

- Заголовки,

- Макети (лейаути),

- Тексти,

- Сторінки оформлення замовлення,

- Форми.

4 кроки, щоб підготуватись до A/B-тестування

Почніть із гіпотези

Перед тим як розпочати A/B-тестування, важливо висунути гіпотезу про те, як зміни в дизайні можуть вплинути на обрані метрики. Чим більше ваша гіпотеза ґрунтується на дослідженнях користувачів і бізнес-інсайдах, тим вища ймовірність успіху тесту. Гіпотеза повинна бути чітко пов'язана з вашими цілями.

Приклад: Ви проводите A/B-тест для сайту електронної комерції. Під час якісних юзабіліті-тестів було помічено, що багато користувачів ігнорують кнопку CTA «Купити». Ваша гіпотеза полягає в тому, що зміна дизайну цієї кнопки підвищить коефіцієнт конверсії, що призведе до зростання продажів.

Визначте, які зміни необхідно внести

Маючи сильну гіпотезу, ви повинні вирішити, що саме змінити в дизайні для її перевірки. Важливо змінювати лише один елемент за раз, щоб результати тесту були точними. Як і на попередньому етапі, рішення про зміни мають базуватися на результатах досліджень для підвищення шансів на успіх.

Приклад: Після якісних юзабіліті-тестів ви вирішили змінити текст на CTA-кнопці. Під час тестування помітили, що користувачі бачили кнопку, але не наважувалися на неї натискати. Тому ви залишаєте візуальне оформлення кнопки незмінним, але змінюєте її підпис на «Купити зараз».

Виберіть контрольні метрики

Визначте, які показники ви будете відстежувати для оцінки успіху вашого A/B-тесту. Серед них повинні бути основні метрики, які покажуть, чи призвела зміна дизайну до очікуваних результатів, а також бар'єрні метрики, що допоможуть оцінити, чи впливають ці зміни позитивно на бізнес.

Приклад: Щоб зрозуміти, чи зміна підпису на «Купити зараз» призведе до збільшення продажів, ви вирішили відстежувати кількість кліків на CTA-кнопку. Додатково, ви будете аналізувати кількість завершених покупок і середній чек. Ці бар'єрні метрики дозволять оцінити, як збільшення кількості кліків впливатиме на загальну ефективність бізнесу.

Визначте термін проведення тесту

Останнім кроком є визначення тривалості A/B-тестування, що залежить від розміру вибірки. Для цього потрібно знати три ключові показники:

- Базове значення контрольної метрики (наприклад, коефіцієнт конверсії, кількість кліків) для оригінального дизайну.

- Мінімальний ефект, що виявляється, — найменша відносна зміна метрики, яку ви хочете виявити.

- Поріг статистичної значущості (зазвичай 95%) — рівень впевненості в достовірності результатів тесту.

Визначивши ці параметри, можна скористатися калькулятором розміру вибірки, щоб визначити, скільки користувачів потрібно для тесту. Навіть за достатнього трафіку рекомендується проводити тестування не менше 1–2 тижнів, щоб врахувати можливі зміни в поведінці користувачів.

Приклад: За даними аналітики, базовий показник кліків для CTA-кнопки «Купити» дорівнює 3%. Ви визначили, що мінімальний ефект, який бажаєте виявити, становить 20%, тобто ви хочете відстежити зміни в межах 3% ± 0,6%. Ви також обрали рівень статистичної значущості 95% (p = 0,05). Використовуючи калькулятор, ви з'ясували, що потрібний розмір вибірки — 13 000 користувачів. Оскільки ваш сайт має приблизно 1 000 користувачів щодня, ви вирішуєте проводити тестування протягом 14 днів. Це забезпечить достатній розмір вибірки та врахує можливі коливання в поведінці користувачів.

Щоб вибрати мінімальний ефект, варто оцінити, яке покращення матиме практичний вплив на бізнес. Наприклад, якщо мінімальний ефект становить 1%, вам доведеться відстежити різницю лише на 0,03%, що вимагатиме набагато більшої вибірки і матиме мінімальний вплив на бізнес.

Вибір інструменту для A/B-тестування

Якщо ви вирішили впровадити A/B-тестування у свої процеси дослідження, перший крок — вибір відповідного інструменту. Існує багато варіантів, і ваш вибір залежить від контексту та потреб вашого бізнесу. Враховуйте такі фактори::

- Бюджет: Інструменти для A/B-тестування можуть варіюватися за ціною — від безкоштовних рішень до дорогих платформ, що коштують кілька тисяч доларів на місяць.

- Складність тесту: Різні інструменти підтримують різні рівні складності тестів: від простих змін кольору або тексту до багатоваріантного тестування та тестів із різними URL-адресами чи кардинальною перебудовою сторінки.

- Простота використання: Вибраний інструмент має бути зручним для вашої команди. Переконайтеся, що вони зможуть швидко його освоїти, а також передбачте достатньо часу для навчання.

- Технічні вимоги: Інструмент має легко інтегруватися з існуючими технічними системами, не створюючи зайвих складнощів.

Після вибору інструменту, що відповідає вашим вимогам, важливо протестувати його перед запуском першого A/B-тесту. Один з надійних способів перевірки — це проведення A/A-тесту, коли обидва варіанти дизайну ідентичні. Це допомагає перевірити, чи правильно налаштований інструмент, оскільки результати такого тесту не повинні виявляти суттєвих відмінностей. Якщо ж таки різниця є, це може свідчити про технічні помилки, які необхідно виправити перед початком A/B-тестування.

Такий підхід дозволяє знизити ризик помилок і гарантує, що ваш інструмент працюватиме коректно під час основних тестів.

Обмеження та поширені помилки в A/B-тестуванні

Як і будь-який інший метод дослідження, A/B тестування пов'язане з певними обмеженнями. При неправильному застосуванні воно може виявитися марною витратою ресурсів або навіть нашкодити.

A/B-тестування не підходить для:

- Сторінки з низьким трафіком: A/B-тестування потребує достатнього обсягу трафіку для отримання статистично значущих результатів. Якщо ваша сторінка має обмежену кількість відвідувачів, результати тесту можуть бути випадковими і ненадійними.

- Тестування кількох змін одночасно: Зміни в кількох елементах дизайну можуть ускладнити аналіз результатів. Можна провести багатоваріантне тестування, але для отримання достовірних результатів знадобиться значно більше даних. Це ускладнить визначення, який саме елемент вплинув на поведінку користувачів.

- Розуміння причин зміни поведінки користувачів: A/B-тестування дає змогу оцінити, як зміни впливають на поведінку користувачів, але не пояснює, чому це сталося. Щоб отримати глибше розуміння, варто поєднувати A/B-тестування з якісними методами, такими як інтерв'ю чи опитування. Це дозволяє застосовувати підхід тріангуляції, що забезпечує більш комплексний аналіз.

Поширені помилки в A/B-тестуванні

- Відсутність чітко визначених цілей: Важливо мати ясне розуміння того, який результат ви очікуєте отримати. Чітко сформульовані цілі допоможуть вашій команді усвідомити мету тестування, визначити пріоритети при створенні варіантів дизайну та скласти дорожню карту A/B-тестування з урахуванням очікуваної окупності інвестицій (ROI).

- Занадто раннє припинення тестування: Ненадійні результати можуть виникнути через недостатню кількість даних. Проте деякі команди відстежують результати в режимі реального часу і роблять висновки занадто рано. Щоб отримати статистично достовірні результати, важливо дочекатися досягнення необхідного розміру вибірки, тільки після цього можна завершувати A/B-тест.

- Тестування без сильної гіпотези: Лише один із семи A/B-тестів виявляється успішним, і цей показник, швидше за все, знижується, якщо ви тестуєте елементи дизайну без переконливої, заснованої на даних гіпотези. Чим більше інформації ви отримуєте з досліджень користувачів, тим вищі шанси на досягнення ефективних результатів.

- Фокус на одній метриці: Часто A/B-тестування має на меті збільшення або зменшення певної метрики. Однак, якщо ви вимірюєте лише один показник для оцінки успішності тесту, ви можете пропустити важливу інформацію. Наприклад, застосування темного патерну в одному з варіантів дизайну може позитивно вплинути на коефіцієнт конверсії, але негативно позначитися на коефіцієнті утримання. Тому важливо відстежувати кілька показників, включаючи бар'єрні метрики, які можуть надати уявлення про реальний вплив змін дизайну.

- Нехтування якісними дослідженнями та бізнес-контекстом: Навіть якщо A/B-тест показує статистично значущий результат, це не означає, що йому слід слідувати беззаперечно. Тестування може призвести до хибнопозитивних або хибнонегативних результатів, можуть виникати помилки вимірювання, або ваш результат може бути статистично значущим, але не практично значущим. Комбінуйте результати A/B-тестів із вашими знаннями про користувачів та бізнес, щоб зробити обґрунтовані висновки.